在不断发展的人工智能世界中,最近推出的 Meta Llama 2 大型语言模型引起了技术爱好者的兴趣。进行了引人入胜的演示,展示了 Llama 2 13B 在英特尔 ARC GPU、iGPU 和 CPU 上的运行。本演示提供了这些设备与这种高级语言模型配对时的潜力的一瞥。

Llama 2 是元维基推出的开源语言模型。它有各种版本,其中一些专门用于聊天。它根据公共数据进行训练,并针对特定目的进行微调。它的性能非常显着,旨在成为开发人员在人工智能项目中创新的工具。Meta 的基本理念是促进 AI 领域的开放式协作。

Llama 2的特点

- 可用性:

- Llama 2 是一个开源语言模型。

- 任何人,无论是个人、创作者、研究人员还是企业,都可以免费访问它。

- 这是 Meta 鼓励人工智能领域开放性的努力的一部分。

- 目标是允许尽可能多的人对模型进行测试、创新和改进。

- 版本和型号:

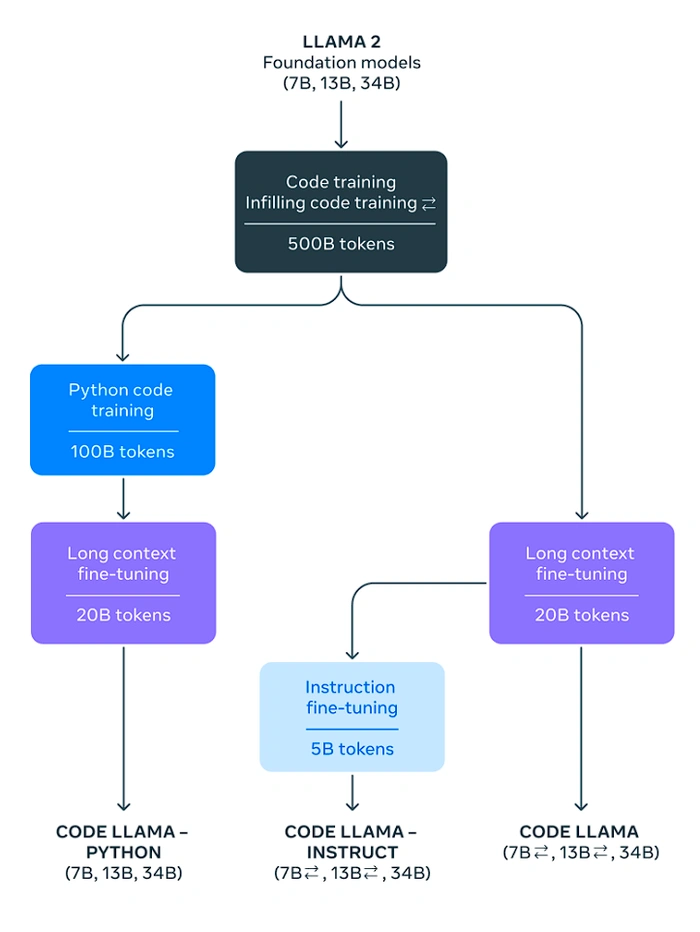

- 骆驼 2 不仅仅是一个模型;它是模型的集合。

- 这些模型的大小各不相同,最小的模型有 7 亿个参数,最大的有 70 亿个参数。

- 一个特定的版本,Llama-2-chat,是专门为对话而设计的。

- 培训和微调:

- Llama 2的初始训练使用了来自公共领域的数据。

- 对于聊天优化版本(Llama-2-chat),进行了额外的培训。这种训练称为监督微调。

- 微调过程还涉及强化学习的技术,使用拒绝抽样和近端策略优化(PPO)等方法。

- 性能:

- 与其他开源聊天模型相比,Llama 2 及其变体在大多数基准测试中都更胜一筹。

- 它有可能取代一些专有模型。

- 该模型已经过评估,以确保它提供有用和安全的响应。

- 使用案例:

- Meta 发布 Llama 2 的目标是为开发者提供一个强大的 AI 工具。

- 该工具可以帮助各种与人工智能相关的项目,使他们能够负责任地进行实验、创新和扩展他们的想法。

- 经营理念:

- 发布 Llama 2 符合 Meta 拥有更开放的 AI 生态系统的愿景。

- Meta 相信协作,并希望广泛的开发人员和研究人员社区在 AI 领域共同努力。

您可以申请在Meta AI官方网站上下载最新的Llama 2 LLM。

在英特尔 ARC GPU、iGPU 和 CPU 上运行 Llama 2

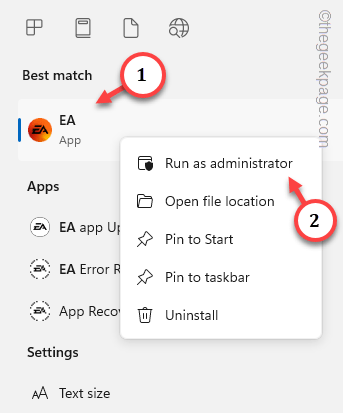

下面的演示涉及在英特尔 Arc GPU 上运行 Llama 2 模型,其惊人的 13 亿和 7 亿个参数。这是使用 Lava CPP 库和 CL Blast 库实现的,它们都有助于加速矩阵乘法和其他数学运算。但是,请务必注意,该方法并未针对英特尔锐炫设备进行全面优化,这意味着它没有充分利用其功能。尽管如此,该过程的速度和可用性值得称赞。

诚然,从源代码编译库的过程漫长而乏味,但在英特尔锐炫设备、英特尔集成 GPU 和 CPU 上的结果显而易见。cmake 工具是此过程的关键组件,需要安装在系统上。此外,需要安装和构建提供加速数学功能的CL Bblast库。此库需要 OpenCL,必须在构建期间提供。

一旦建立了CL Bblast库,就会生成CL blast.dll和GL blast.lib文件。然后这些文件被用来编译骆驼.cpp库。生成的最终可执行文件用于在 Arc GPU 和集成 GPU 上运行 Llama 模型。提供环境变量的平台路径非常重要,这样程序才能找到它。

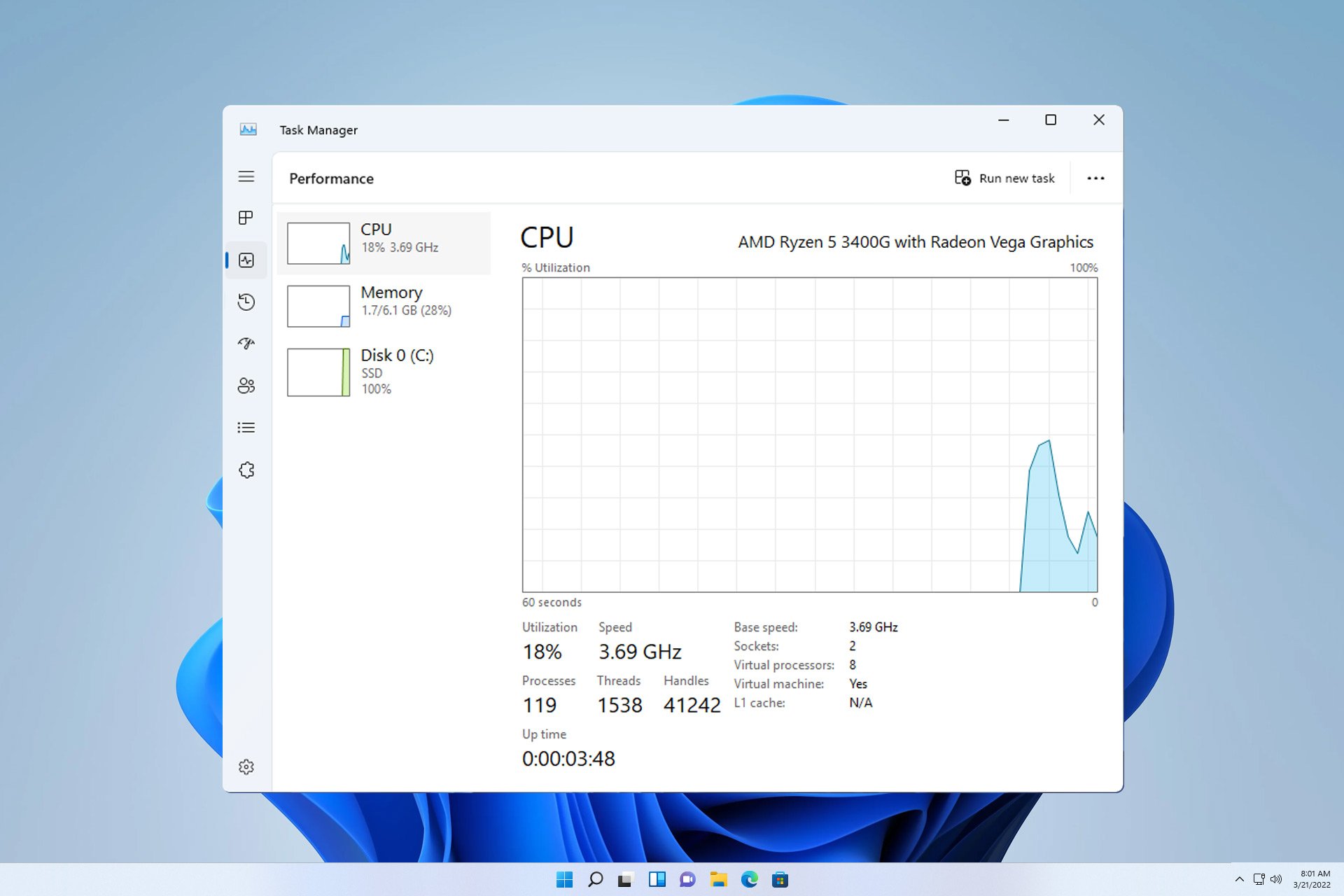

Llama 13亿模型是8位量化的,可以在GPU上运行并提供快速预测。Llama 7亿模型也可以在GPU上运行,并提供更快的结果。该模型也可以在集成GPU上运行,虽然速度较慢,但仍可用。在 CPU 上运行模型会导致高 CPU 活动,但它仍然是一个可行的选择。

在英特尔 ARC GPU、iGPU 和 CPU 上运行 Llama 2 13B 的探索证明了人工智能领域令人兴奋的进步,以及这些设备的潜力,以及在经济实惠的计算机上本地运行这些强大的大型语言模型的能力。