在人工智能和机器学习领域,NVIDIA GH200 Grace Hopper Superchip首次亮相。超级芯片在MLPerf行业基准测试中表现出卓越的性能,沉着地运行所有数据中心推理测试。这一成就证明了 NVIDIA 自 2018 年 MLPerf 基准测试启动以来致力于突破人工智能技术的界限及其始终如一的性能领先地位。

GH200 Superchip是Hopper GPU和Grace CPU的独特组合。这种合并提供了更多的内存、带宽以及在 CPU 和 GPU 之间转移功率以优化性能的能力。这种创新设计使 NVIDIA 的 H100 GPU 和 Grace Hopper Superchips 能够在 MLPerf 的所有数据中心测试中处于领先地位,包括计算机视觉、语音识别和医学成像的推理。

英伟达GH200格雷斯漏斗超级芯片

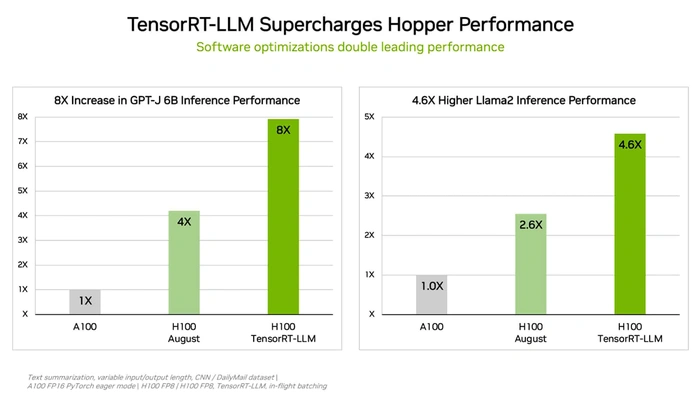

为了进一步优化推理,NVIDIA 开发了 TensorRT-LLM,这是一款开源生成 AI 软件。该软件使客户能够在不增加成本的情况下将其 H100 GPU 的推理性能提高一倍。在H100 GPU上使用时,与在没有软件的情况下运行GPT-J 8B的上一代GPU相比,TensorRT-LLM提供了高达6倍的性能提升。这是性能的重大飞跃,表明了 NVIDIA 致力于为客户提供价值的承诺。

NVIDIA 的 L4 GPU 在最新的 MLPerf 基准测试中也提供了令人印象深刻的性能。它们提供的性能比额定功耗高出近 6 倍的 CPU。这些GPU可从Google Cloud和许多系统制造商处获得,为从消费者互联网服务到药物发现等行业的客户提供服务。

为了进一步展示其创新方法,NVIDIA 应用了一种新的模型压缩技术,在 L4 GPU 上运行 BERT LLM 实现了高达 7.4 倍的性能提升。这项技术展示了 NVIDIA 致力于不断提高其产品性能的承诺。

与上一轮相比,NVIDIA Jetson Orin 系统模块在对象检测方面也显示出高达 84% 的显着性能提升。这是 Edge AI 和机器人场景中的常见用例,进一步证明了 NVIDIA 技术的多功能性和适用性。

MLPerf 基准测试得到了 70 多家组织的支持,包括阿里巴巴、Arm、思科、谷歌、哈佛大学、英特尔、Meta、Microsoft 和多伦多大学,是衡量人工智能行业绩效的可靠指标。NVIDIA 在这些基准测试中的卓越表现证明了其技术实力和对创新的承诺。

为了促进透明度和协作,NVIDIA 基准测试中使用的所有软件都可以从 MLPerf 存储库获得。这让每个人都能取得同样的世界级成果,培养人工智能行业共享学习和进步的精神。

NVIDIA GH200 Grace Hopper Superchip在MLPerf基准测试中的卓越性能证明了NVIDIA致力于突破AI技术界限的承诺。凭借 Hopper GPU 和 Grace CPU 的创新组合、开源软件和新模型压缩技术,NVIDIA 继续在 AI 训练和推理方面处于领先地位。